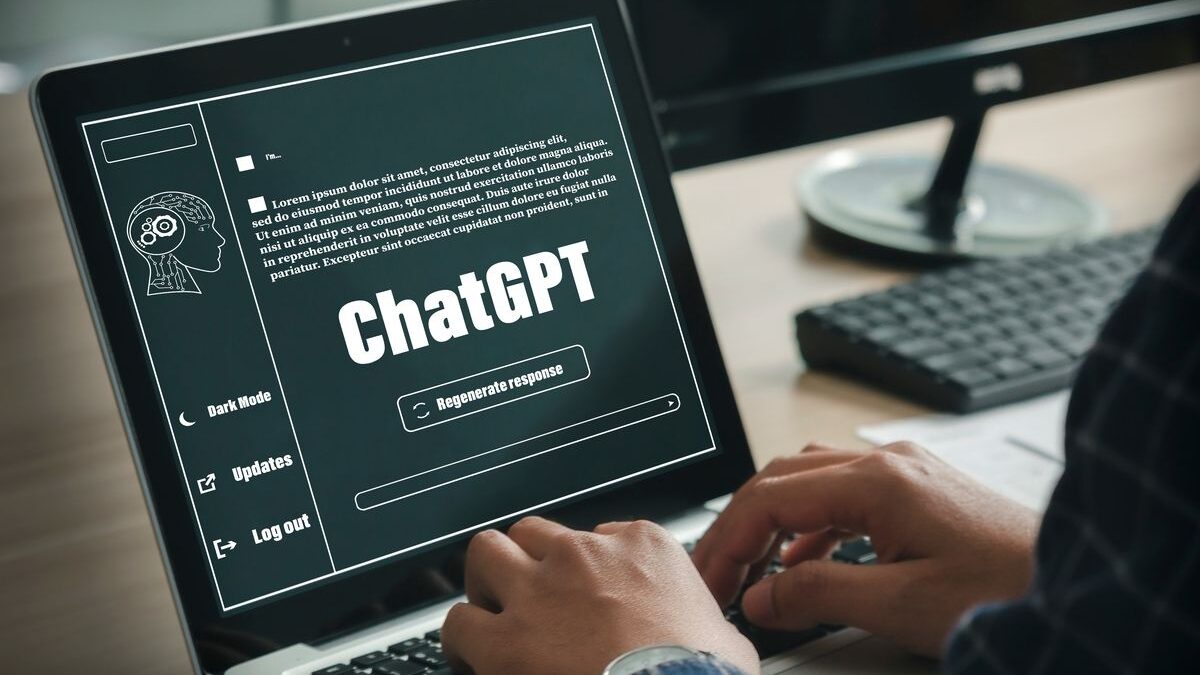

Em um mundo cada vez mais digitalizado e tecnologicamente avançado, é inevitável que novas ferramentas e sistemas de inteligência artificial (IA) estejam constantemente surgindo. Um dos exemplos mais recentes e impressionantes é o ChatGPT, um modelo de linguagem capaz de realizar conversas sofisticadas e interativas com os usuários. Desenvolvido pela OpenAI, o ChatGPT utiliza uma combinação de técnicas e tecnologias para fornecer respostas humanas e envolventes. Neste artigo, exploraremos os tipos de tecnologia que o ChatGPT utiliza e como eles funcionam para o funcionamento desse sistema.

Um dos principais componentes do ChatGPT é uma chamada técnica de “aprendizado por garantia”. Esse método envolve a criação de um agente de IA que aprende a interagir com o ambiente e aprimora seu desempenho com base no feedback recebido. O ChatGPT foi treinado usando uma versão anterior, conhecida como GPT-3, com aprendizado por reforço. Ele aprendeu a partir de conversas entre agentes humanos simulados, que cumpriram o papel de usuário e de assistente, fornecendo exemplos de diálogos relevantes. O modelo foi recompensado por fornecer respostas adequadas e relevantes em relação ao contexto das conversas. Essa técnica permitiu ao ChatGPT aprender a lidar com uma ampla variedade de perguntas e solicitações.

Outro tipo de tecnologia que o ChatGPT utiliza é o chamado modelo de linguagem com transformadores. Os transformadores são uma arquitetura de rede neural que permite ao algoritmo processar sequências de dados, como palavras, em uma relação complexa de dependências. Essa arquitetura é especialmente adequada para tarefas de processamento de linguagem natural, como compreensão e geração de texto. O GPT-3, do qual o ChatGPT derivou, é um exemplo de modelo de linguagem baseada em transformadores que utiliza a técnica de codificação e decodificação, em que a entrada de texto é transmitida em um vetor de representação e, em seguida, decodificado para gerar uma resposta adequada. Essa abordagem permite que o ChatGPT responda de forma mais coerente e natural às práticas dos usuários.

Além disso, o ChatGPT utiliza tecnologias de processamento de linguagem natural (NLP) para entender a entrada do usuário e gerar respostas seguidas. O NLP é uma área de pesquisa que se concentra em como as máquinas podem compreender e interpretar a linguagem humana. É uma disciplina multidisciplinar que envolve conhecimento de linguagem, ciência da computação e inteligência artificial. O ChatGPT emprega técnicas de NLP, como análise sintática, análise semântica e reconhecimento de entidades, para compreender o contexto e a intenção do usuário. Essas informações são então usadas para gerar respostas relevantes e coerentes.

Por fim, o ChatGPT também se beneficia de um enorme conjunto de dados para o treinamento. O GPT-3 foi treinado em uma ampla gama de documentos da web, totalizando bilhões de palavras. Essa vasta quantidade de informações permite ao ChatGPT adquirir conhecimentos abrangentes e compreensão de uma ampla gama de recursos. No entanto, essa abordagem também pode levar a algumas restrições, como respostas externas ou informações desatualizadas. Portanto, é importante que os usuários saibam que o ChatGPT não possui conhecimento “real-time” e pode avaliar criticamente conforme as informações fornecidas.

Em suma, o ChatGPT utiliza uma combinação de técnicas e tecnologias para fornecer respostas humanas e envolventes aos usuários. O aprendizado por reforço, os transformadores, o processamento de linguagem natural e o uso extensivo de dados são elementos fundamentais para o funcionamento desse sistema. Essa interseção de tecnologias permite um processamento sofisticado da linguagem e a capacidade de engajar os usuários em conversas interativas e relevantes. No entanto, é importante lembrar que o ChatGPT tem suas restrições e que as informações fornecidas devem ser avaliadas criticamente.

Quer saber usar a seu favor? Fale comigo.

Referências:

1. OpenAI. “ChatGPT.” Disponível em: https://openai.com/research/chatgpt.

2. Vaswani, Ashish, e outros. “Atenção é tudo que você precisa.” Avanços em sistemas de processamento de informações neurais, 2017.

3. Sutton, Richard S. e Andrew G. Barto. “Aprendizado por reforço: uma introdução.” Imprensa do MIT, 2018.

4. Jurafsky, Daniel e James H. Martin. “Fala e processamento de linguagem.” Pearson Education, 2019.